유 온리 룩 원스

둘러보기로 이동

검색으로 이동

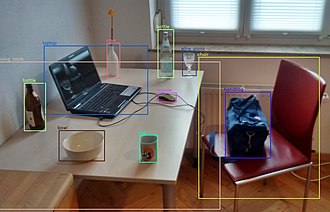

유 온리 룩 원스(You Only Look Once, YOLO)는 합성곱 신경망을 기반으로 한 일련의 실시간 객체 탐지 시스템이다. 조셉 레드몬 등에 의해 처음 소개되었다. 2015년[1] YOLO는 여러 번의 반복과 개선을 거쳐 가장 인기 있는 객체 감지 프레임워크 중 하나가 되었다.[2]

"유 온리 룩 원스"(You Only Look Once)라는 이름은 단일 이미지에 수천 개가 필요한 R-CNN과 같은 이전 영역 제안 기반 기술과 달리 알고리즘이 예측을 위해 신경망을 통과하는 단 한 번의 순방향 전파 통과만 필요하다는 사실을 나타낸다.

개요

R-CNN 및 오버피트(OverFeat)와 같은 이전 방법과 비교하여 YOLO는 여러 위치와 규모의 이미지에 모델을 적용하는 대신 단일 신경망을 전체 이미지에 적용한다.[3] 이 네트워크는 이미지를 영역으로 나누고 각 영역에 대한 경계 상자와 확률을 예측한다. 이러한 경계 상자는 예측 확률에 따라 가중치가 부여된다.

오버피트

오버피트(OverFeat)는 동시 객체 분류 및 위치 파악을 위한 초기 영향력 있는 모델이었다.[3][4] 그 아키텍처는 다음과 같습니다:

- 이미지 분류 전용 신경망을 훈련한다("분류 훈련 네트워크"). 이는 알렉스넷과 같은 것일 수 있다.

- 훈련된 신경망의 마지막 계층이 제거되고, 가능한 모든 객체 클래스에 대해 마지막 계층에서 신경망 모듈("회귀 신경망")을 초기화한다. 기본 네트워크에는 매개변수가 고정되어 있다. 회귀 네트워크는 객체 경계 상자의 두 모서리에 대한 좌표를 예측하도록 훈련되었다.

- 추론 시간 동안 분류 훈련 네트워크는 다양한 확대/축소 수준과 자르기를 통해 동일한 이미지에 대해 실행된다. 각각에 대해 클래스 레이블과 해당 클래스 레이블에 대한 확률을 출력한다. 그런 다음 각 출력은 해당 클래스의 회귀 네트워크에 의해 처리된다. 이로 인해 클래스 레이블과 확률이 포함된 수천 개의 경계 상자가 생성된다. 이러한 상자는 단일 클래스 레이블이 있는 단일 상자만 남을 때까지 병합된다.